Alguna vez un amigo motociclista me contó que solamente había dos tipos de perfiles de dueños de motocicletas: los que ya se cayeron y los que aún no se caen.

Creo que a estas alturas puedo hacer una analogía similar con el Diseño centrado en las personas. Hay dos tipos de Diseñadores: los que ya justificaron un entendimiento cualitativo a alguien que solo entiende datos cuantitativos y los que aún no les toca.

Eventualmente todos somos víctimas de este cuestionamiento. Probablemente llegue por un cliente que está familiarizado con el Marketing, o por un dueño de negocio que te dice que tu muestra es pequeña.

La verdad es que no importa de dónde o por qué llegue el cuestionamiento. El entender la diferencia entre los tipos de datos, cuándo aplicarlos y qué significan es tan fundamental como conocer de heurísticas, affordances y usabilidad. Es una herramienta cotidiana de trabajo que determina la calidad de tus resultados y el entendimiento que comunicas de un proyecto.

Definiciones

Como es costumbre, primero establezcamos definiciones para asegurarnos que hablamos el mismo idioma.

La data cuantitativa es aquella que nos permite expresar resultados de manera numérica. Es cuantitativa porque se puede contar. Se obtiene por medio de herramientas que arrojan datos cuantificables como encuestas, y para que tengan algún tipo de significado generalmente buscan algún número de relevancia estadística.

La data cualitativa es toda aquella que no es cuantitativa (por eso expliqué primero la cuantitativa) lo que, por definición, implica que no se puede medir, agrupar o rankear. No se puede presentar en tablas, gráficas de barras, pay, porcentajes y por lo tanto es imposible que puedan generar algún tipo de estadística. Generalmente se obtiene por medio de entrevistas a profundidad y observaciones en contexto.

Por poner un ejemplo práctico:

Según este artículo, solo 32% de los habitantes de Filipinas confían en las vacunas. Este es un decenso cuantificable en la cantidad de gente que contestó “Completamente de acuerdo” ante la pregunta “Cree usted que las vacunas son importantes?” que solía ser del 95%. Este es un dato cuantitativo que nos permite identificar una métrica cuantificable y que tiene que ser estadísticamente representativa para ser válida, es decir que se tienen que obtener suficientes respuestas para cumplir con un margen de confianza establecido matemáticamente según el tamaño de la población total, que nos permite establecer un tamaño “muestra”. Este tipo de estudios frecuentemente se hacen en estudios de mercado y en análisis poblacionales. Incluso el famoso ‘rating’ televisivo y de radio es una representación estadística a partir de una muestra.

Según ese mismo artículo, la razón cualitativa a la que se adjudica el descenso es a “un incremento en la desconfianza pública alrededor de una vacuna y un aumento en la ansiedad relacionada con la vacunación en general”. Esta última afirmación es una generalización y no refleja que los usuarios literalmente hayan dicho que sentían ansiedad o desconfianza, sino que hay una interpretación en el tono y manera de algunos individuos que se puede describir y generalizar con esa descripción. Eso no quiere decir que 68% de la población Filipina diga, textualmente, sentir desconfianza. Pero nos ayuda a entender a mayor profunidad por qué está pasando.

Una data nos ayuda a entender por qué sucede un aspecto de nuestra realidad, el otro tipo nos permite entender qué tan frecuentemente sucede eso que observamos, en términos que podamos medir.

Necesitamos ambos tipos de data para pintar una imagen completa de la realidad, sin embargo esa misma realidad también nos limita respecto al alcance y nivel de profunidad que podemos obtener cuando tenemos recursos limitados como tiempo y dinero. ¿Te imaginas que los investigadores tuvieran que obtener respuestas cualitativas y a profunidad de absolutamente todos los participantes de la muestra cuantitativa? ¿Te imaginas que en ves de una respuesta con 5 opciones predefinidas, fuera una pregunta abierta? Habría que escuchar miles de horas de entrevistas, revisar cientos de hojas de anotaciones y además eventualmente terminarían sesgando la prueba porque tendrían que generalizar los hallazgos de una manera que se puedan presentar y comunicar, porque nadie tendría tiempo de leer miles de opiniones y frases de todos los individuos entrevistados. Es simplemente imposible.

Definiciones dentro de UX

Como diseñadores, nosotros tenemos acceso a herramientas de investigación que nos permiten obtener diferentes tipos de datos según el tipo de hipótesis que queramos validar. Incluso en algunos casos en los que no tenemos la posiblidad de obtener información directamente, debemos tener la capacidad de poder obtener información de fuentes oficiales o autoridades de los cuales podamos extrapolar una hipótesis. No porque no sea el escenario ideal no significa que no nos enfrentemos a situaciones así.

Sin embargo, la investigación que hacemos rara vez es de uso exclusivo para nosotros. En muchos casos los equipos de diseño responden a áreas de Marketing, que acostumbrados a la relevancia estadística de la información que manejan, en más de una ocasión me ha tocado escuchar el “¿Cuántas pruebas se hicieron?”, buscando desarticular o contra argumentar una hipótesis bajo la falsa premisa de que al no tener un número “suficiente” de incidencias, entonces no es algo que debería requerir atención.

Dejemos algo bien claro. La data cualitativa no necesita representación estadística. Si una app genera una sensación de frustración en los usuarios, no importa si es con uno o con trescientos usuarios, un hallazgo es que la app genera una sensación de frustración. Punto.

La data cualitativa no se cuantifica porque no pretende explicar una frecuencia, pretende explicar por qué. Se profundiza, se pregunta, se trata de entender de fondo cómo piensa, siente o qué necesita una persona. No puedes decir algo como “5 de cada 10 usuarios se frustraron” porque no hay un criterio único para expresar la frustración. Algunos usuarios se ríen, algunos usuarios se te quedan viendo, otros genuinamente no dan señal alguna de frustración y actúan con confianza aunque no tengan idea de qué están haciendo. ¿Cómo justificas estadísticamente una reacción emocional como la frustración? ¿Cuándo el usuario llora? ¿Cuándo textualmente te dice “me siento frustrado”? ¿Les vas a hacer una encuesta al final y preguntarles “te frustraste”? ¿Tú crees que te van a contestar la verdad?

Todos los usuarios siempre te van a decir que está “bonita” tu interfaz cuando se las presentas. Todos van a asentir con la cabeza y te van a decir que entienden lo que están viendo, mientras leen en voz alta los textos en pantalla. Si estás haciendo una exploración cualitativa y buscando cuantos usuarios dicen en voz alta y literalmente que “les gusta”, eres un terrible, terrible investigador (tú sabes quién eres). Exploramos cualitativamente para entender qué es lo que el usuario piensa, necesita y hace cuando no estás tú sentado frente a él en un ambiente controlado, acompañándolo en cada pantalla. ¿Se desesperaría y cerraría la aplicación en menos de 5 segundos? ¿Qué esperaría ver en primer lugar? ¿Qué cree que va a lograr por hacer algo con tu app? ¿Qué entiende por los textos en pantalla? ¿Cómo se siente?

Exploramos cualitativamente para adelantarnos a sus necesidades y para entenderlas, no para cuantificarlas o simplificarlas a un número. Exploramos cuantitativamente cuando queremos identificar si una necesidad es estadísticamente prevalente en una población.

Aplicación

Ok. Ya quedó claro la diferencia y la importancia de cada tipo de data ¿Ahora qué? ¿Cómo sabemos cuándo aplicar cada una? Todo diseñador que se respete va contestar con un sonoro y tajante “Depende”, pero no quiero que te vayas con las manos vacías, así que te voy a dar una recomendación que te puede servir cuando realmente no sepas qué hacer.

La data cualitativa te ayuda a entender. La data cuantitativa te ayuda a medir.

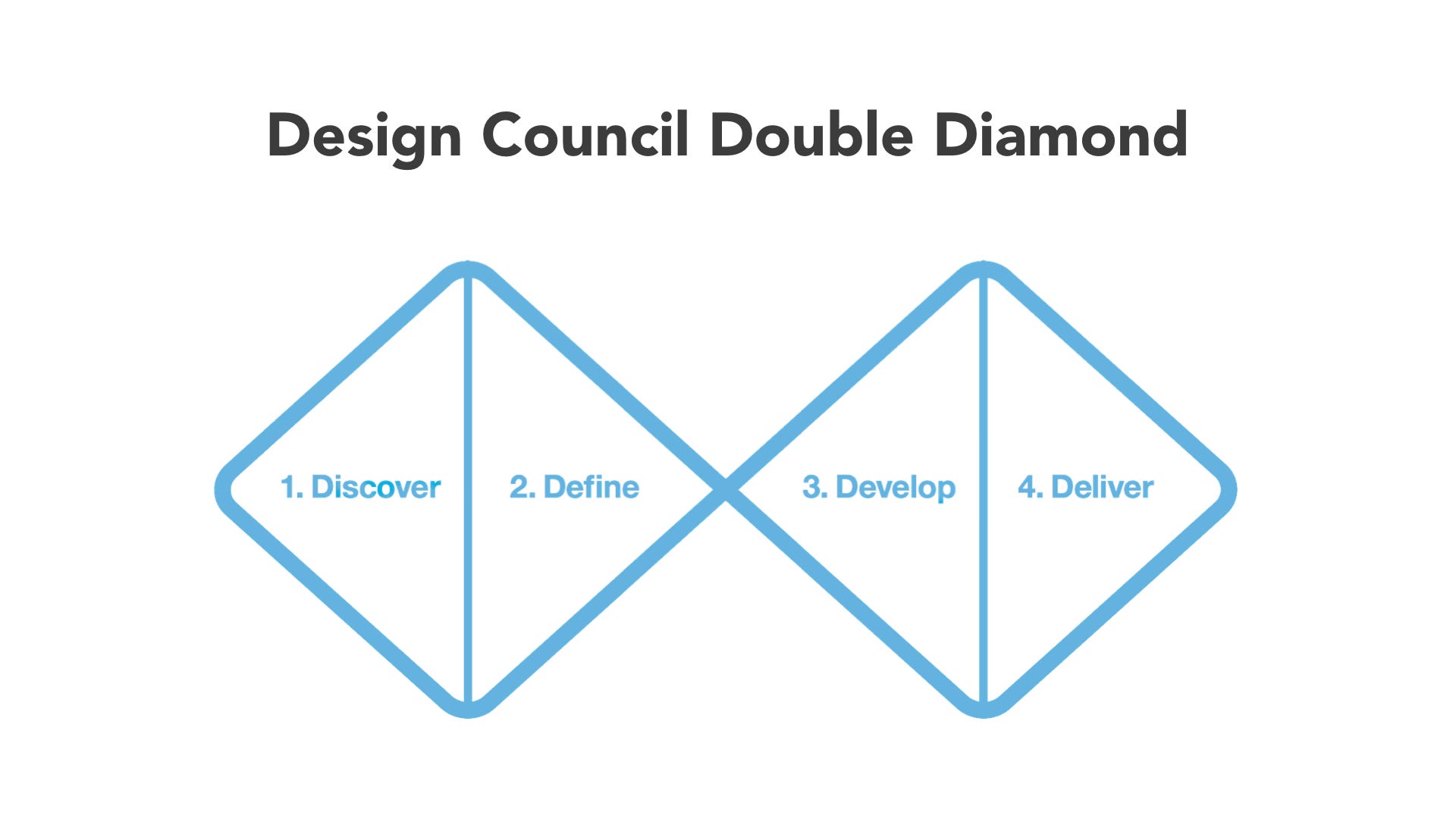

Todo proceso de diseño pasa por las fases del doble diamante:

- Descubrimos, en dónde hay divergencia para explorar perfiles, necesidades, problemas, How Might We y demás.

- Definimos, en dónde llegamos a una convergencia de esa exploración y hacemos una hipótesis de solución única.

- Desarrollamos, en dónde vuelve a haber divergencia para explorar diferentes modelos de solución, flujos, pantallas y textos.

- Entregamos, haciendo una convergencia de la mejor solución y la ponemos en manos de los usuarios.

En la primera etapa, te sirve más tener data cualitativa que cuantitativa. Cómo estás desarrollando una hipótesis de solución, te sirve entender por qué pasan las cosas. Necesitas explorar el mapa mental que tienen los diferentes perfiles de usuario o, incluso, explorar si el perfil de usuario que quieres existe en primer lugar. Los entrevistamos y platicamos con ellos para descubrir oportunidades, necesidades, puntos de dolor, frustración y cómo resuelven actualmente su problema. En este punto no nos importa cuántos, nos importa entender por qué.

Una vez que ya tienes una hipótesis de solución, te sirve más la data cuantitativa. La pregunta que más frecuentemente quieres resolver va en función a “¿Cuántos usuarios les sirve esta herramienta?”. Aquí te sirve tener tasas de completud, para entender si tu flujo se puede completar. Tree testing para saber si se puede navegar. Funnels, flujos, encuestas de satisfacción para saber si a los usuarios les sirvió o no.

Entonces, como una gran generalidad (recuerda, siempre depende). Si aún no sabes qué hacer, concéntrate en explorar cualitativamente. Si ya tienes algo hecho y lo que quieres saber es si algo funciona sin que te preocupe por qué, concéntrate en explorar cuantitativamente.

Literatura extra

Te comparto algunas ligas de especialistas en el tema por si necesitas argumentarle al jefe de Marketing por qué nosotros podemos hacer pruebas con pocos usuarios y aún así considerar que nuestros hallazgos son válidos.

Primer artículo: Probar con 5 usuarios te ayudará a entender el 85% de los problemas cualitativos de la usabilidad de tu sistema. Básicamente, si 5 usuarios no pueden completar un flujo de tu app, es casi seguro que si la lanzas al mercado, 100,000 usuarios no podrán completar el flujo. Nielsen dice que pruebes en pequeño, pero que pruebes rápido y frecuentemente.

You Only Need to Test with 5 Users — Jakob Nielsen

You want to run multiple tests because the real goal of usability engineering is to improve the design and not just to document its weaknesses. After the first study with five participants has found 85% of the usability problems, you will want to fix these problems in a redesign.

Segundo artículo: Medir un atributo cualitativo como la lealtad o la satisfacción con una métrica cuantitativa como el Net Promoter Score (NPS) arroja resultados falsos que pueden hacer daño a toda una organización. El artículo propone maneras alternativas de medir si los usuarios están satisfechos con la experiencia o no.

Net Promoter Score Considered Harmful (and What UX Professionals Can Do About It) — Jared Spool

We’ve seen many participants rate a 0 because they couldn’t think of anyone to give the recommendation to. Others rated a 10 because they had friends who worked at the company. When the company offers an incentive to respond, say a chance to win a $100 Amazon gift certificate, we’ve seen participants put a high score in because “They’ll never give the prize to someone who gives them a zero.”

We’ve learned that NPS doesn’t tell us anything about the customer’s experience or their loyalty. In fact, we can’t trust NPS to tell us anything useful.

Artículo 3: La mejor manera de medir si un producto funciona o no, es en ambiente productivo. Lanzar inicia una “conversación” con tus usuarios, que son clientes reales, en un contexto real, que te permite obtener métricas claras, fidedignas y estadísticamente relevantes. La mejor fuente de data cuantitativa son tus propios analytics. Solo recuerda que no puedes extrapolar necesidades cualitativas de ellos. Te dice si tu producto “funciona” o no. No por qué.

Fixed time, fixed scope projects always end in 1 of 3 ways. None of them good. — Jeff Gothelf

Launching publicly simply begins the process of learning how right (or wrong) our assumptions were. It is the start of a continuous conversation with your target audience and the fastest way to learn how to optimize your system. The sooner you can get something to market, the sooner you can make the system better.

Recuerda. Entender los tipos de datos y saber utilizarlos para argumentar hallazgos es una herramienta poderosa que debes usar con mucha responsabilidad.